-

从2021年4月起,论坛网上药店重新开放!详情查看

-

从2023年10月10日开始,华夏中医论坛启用备用域名tcmbe.com 详情查看

-

关于论坛电子书等资源下载权限的说明!详情查看

-

论坛官方2000人QQ群,欢迎加入!详情查看

-

对所有可能涉及版权的资源,论坛均不再公开展示!详情查看

您正在使用一款已经过时的浏览器!部分功能不能正常使用。

请尝试升级或使用 其他浏览器。

请尝试升级或使用 其他浏览器。

其他 见什么人,说什么话:人机共通的交流法则——AI生成答复的流程与原理,及其分化用户认知能力的效应

- 主题发起人 梦回杏林

- 开始时间

这个不奇怪,AI是根据你的观点来推演的,只要你的观点不那么太离谱,AI基本上都会附和你,除非你的观点是完全错误的非主流观点,AI才会坚持反驳你。实际上,你跟AI沟通,是没法获取真正有价值的新思想的。

这个不奇怪,AI是根据你的观点来推演的,只要你的观点不那么太离谱,AI基本上都会附和你,除非你的观点是完全错误的非主流观点,AI才会坚持反驳你。实际上,你跟AI沟通,是没法获取真正有价值的新思想的。

人工开题定调,AI具体撰写,得到的论文的水平主要取决于这个使用者的水平。

如果使用者提问中预设的【总论点、分论点、探索思路和证据采集方向】正确,即论文骨架站得住脚,那么与AI合著的论文就是一篇优质的文献。

AI除了能够帮忙自动搜集相关证据进行填充润色,增加论文的可读性和可信任度。

还可以让使用者在它呈现的丰富的论据、数据之中,获取新的知识,得到新的启发。

至于提问中事先预置的观点和思路,自然是使用者这个真人根据自己的【认知体系】和【实践经验】得来的。

前不久我还真发现过因为自己认知偏差预置了一个错误的观点,结果AI找了一堆有利于我的观点的论据来加以论证的情况。

但过了几天回顾反思的时候始终觉得自己的观点比较牵强、没有十足的把握,又重新在不预设判断的情况下问了AI同样的问题。

果然这次AI的总结跟我先前的观点差别较大,其实就是三阴性腺癌中医主证分布的问题,修正后的观点我已经发在论坛上了。

三阴性腺癌原先我的判断是【脾虚是主证】,但实际上【气郁才是主证】:https://www.tcmbe.com/threads/456588/

因为实践中是没有接触过这样的患者的,但从网络视频上看到过一两例,样本量太小视角太窄,难以得出准确的群体特征判断。

【偏差共鸣、偏差放大】现象并不是AI的专利,现实中的人以群分、人群聚集、网络上的因人推荐、茧房效应,都会产生这种现象。

即使现代医学的科研及其结论中,这种现象也非常普遍:

实验者的研究思路偏差(追踪的靶点、通道、标志物不对)和实验设计不合理(参照组设置、分析基准选择)都可能得到错误甚至相反的结论。

如何有效的使用AI、避免得到错误的回应,需要使用者不断的实践、提问、反思……再实践、再探讨、再反思……再实践。

在探讨的过程中使用【交叉火力验证法】:既让AI搜集支持自己观点的证据,又让AI搜集不利于自己观点的证据并对自己的观点发起最强质疑。

具体操作方法如下:

三阴性腺癌原先我的判断是【脾虚是主证】,但实际上【气郁才是主证】

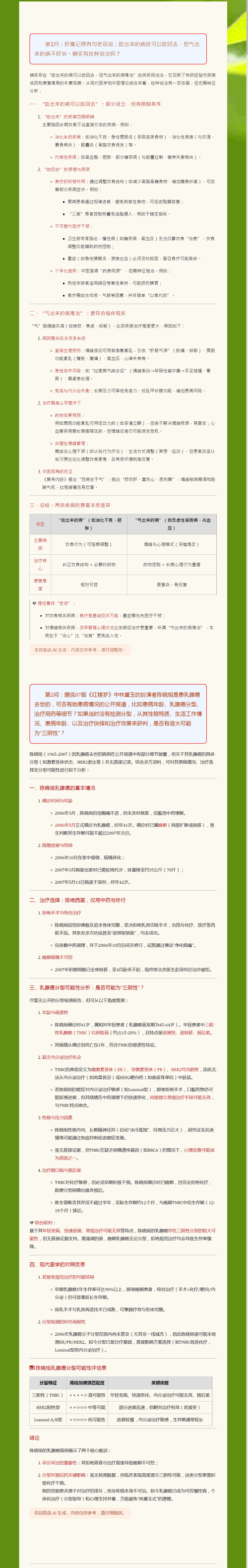

三阴性乳腺癌核心病机为【气郁】,而不是【脾虚】和【湿热、痰湿、瘀毒】,的中西医病理逻辑验证:

一、首先排除【瘀毒】,因为它是所有癌症的最终病机,没有特异性

二、第二排除【湿热、痰湿】,因为它是非激素依赖型-->即非营养过剩依赖-->即非饮食不节依赖,故湿热和痰湿不是其核心病机

三、最后排除【脾虚】,年轻人群高发,40岁以下风险是50岁以上的2倍,如果是自然衰老或者积劳积病而致脾虚,发病率应该随年龄增长,故排除

可见三阴性乳腺癌是【压力癌】、【生气癌】。

临床上,三阴性乳腺癌在乳腺癌的各种分型中是疗效和预后最差的。

所以【吃出来的病还能吃回去,但气出来的病不好治】这句老话也能从一个侧面反证三阴性乳腺癌的核心病机为【气郁】。

附件

-

404.2 KB 查看: 26